实验发现,tensorflow的tensor张量的shape不支持直接作为tf.max_pool的参数,比如下面这种情况(一个错误的示范):

|

1

|

self.max_pooling1 = tf.nn.max_pool(self.l_6, ksize = [1, tf.shape(self.F1)[0], 1, 1], strides = [1, 1, 1, 1], padding = 'VALID', name = 'maxpool1') |

我在max_pool的过程中想对特征每一列进行max_pooling,但因为tensor F1张量没有值,而ksize此处需要一个int类型的常量,所以tf.shape(self.F1)[0]无法作为ksize的参数。

一些人的做法是固定行数,比如pointnet固定为2048个点,但这样做需要重新采样,过于麻烦。

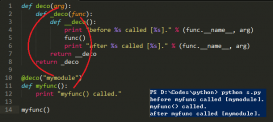

而既然tensorflow不提供标准的max_pool层实现,其实可以自己实现每一列取最大值的操作,充当自己的max_pool。如下图所示:

|

1

2

3

|

def max_pooling(self, NC): out = tf.reduce_max(NC, reduction_indices=[0]) return out |

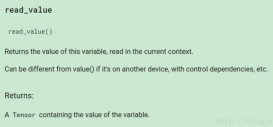

利用reduce_max刚好能实现这个操作,其中reduction_indices可以指定取哪一维的最大值。这个函数的详细功能可以参考官方文档。

这种情况和tf.reshape不同,tf.reshape是可以使用tf.shape(tensor)[i]的,可能两者对参数的要求不一样。

以上这篇tensorflow之获取tensor的shape作为max_pool的ksize实例就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持服务器之家。

原文链接:https://blog.csdn.net/change_things/article/details/78878763