一、简介

antograd包是Pytorch中所有神经网络的核心。autograd为Tensor上的所有操作提供自动微分,它是一个由运行定义的框架,这意味着以代码运行方式定义后向传播,并且每一次迭代都可能不同

二、TENSOR

torch.Tensor是包的核心。

1.如果将属性.requires_grad设置为True,则会开始跟踪针对tensor的所有操作。

2.完成计算之后,可以调用backward()来自带计算多有梯度。该张量的梯度将积累到.grad属性中。

3.要停止tensor历史记录的跟踪,可以调用.detach(),他将与计算历史记录分离,并防止将来的计算被跟踪

4.要停止跟踪历史记录(和使用内存),可以将代码块使用with torch.no_grad():包装起来。在评估模型时候,很有用,因为模型在训练阶段具有requires_grad=True的可训练参数有利于调参,但是在评估阶段不需要梯度

5.还有一个对于autograd实现非常重要的就是Function。tensor和Function互相连接并构建一个肺循环图,他保存整个完整的计算过程的历史信息。每个张量都有一个.grad_fn属性保存着创建了张量的Function的引用(如果用户自己创建的张量,那么grad_fn是None)

6.如果想计算导数,可以调用Tensor.backward().如果Tensor是标量(包含一个元素数据)则不需要指定任何参数backward(),但是如果他有更多元素,则需要指定gradient参数来指定张量的形状

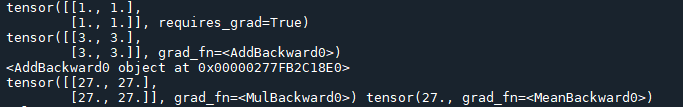

import torch # 创建一个张量,设置requires_grad=True x=torch.ones(2,2,requires_grad=True) print(x) # 针对张量操作 y=x+2 print(y) print(y.grad_fn)#y作为操作的结果被创建,所以他有grad_fn # 对y操作 z=y*y*3 out=z.mean() print(z,out)

运行结果

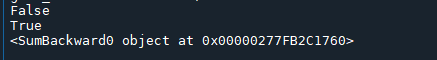

# 如果在变量输入过程中没有提供相应参数,输入的标记默认为False,requires_grad_()会改变张量的requires_grad标记 a=torch.randn(2, 2) a=((a*3)/(a-1)) # 前面没有设置requires_grad,固会输出False print(a.requires_grad) a.requires_grad_(True) # 经过上面语句的更改之后,此处应该输出True print(a.requires_grad) b=(a*a).sum() # 输出梯度信息 print(b.grad_fn)

运行结果

三、梯度

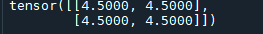

现在向后传播,因为输出包含了一个标量,out,backward()等同于out.backward(torch.tensor(1,))

out.backward()#向后传播 print(x.grad)#打印梯度

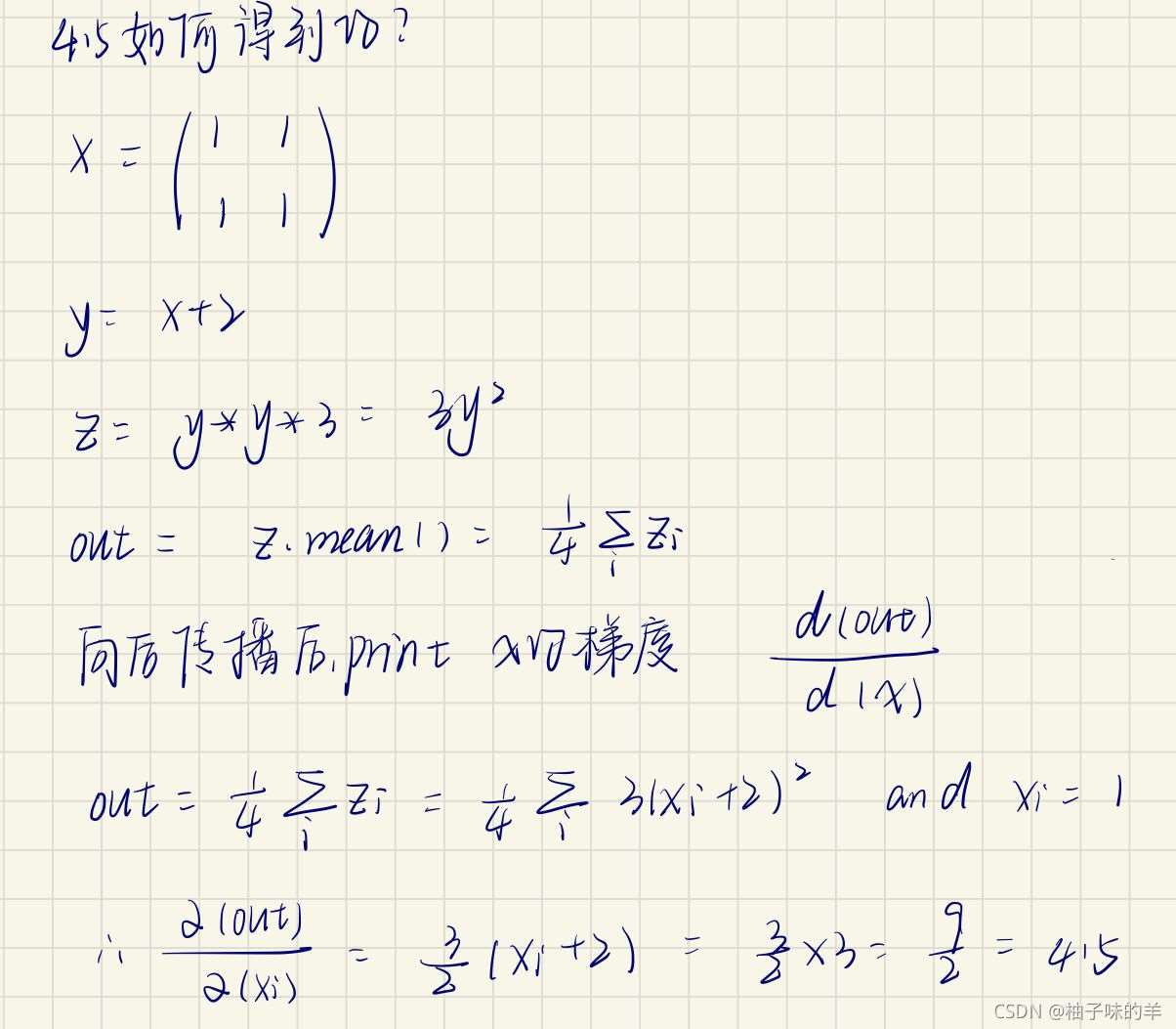

运行结果

原理

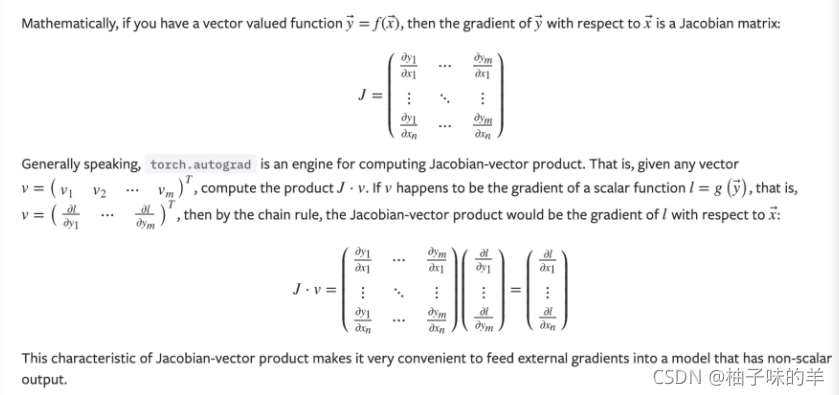

四、Example――雅克比向量积

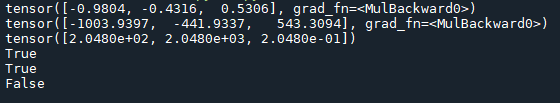

# 雅克比向量积 x=torch.randn(3,requires_grad=True) y=x*2 print(y) while y.data.norm()<1000: y=y*2 print(y)#此时y不是标量,torch.autograd 不能够直接计算整个雅可比,但是如果我们只想要雅可比向量积,只需要简单的传递向量给 backward 作为参数 v=torch.tensor([0.1,1.0,0.0001],dtype=torch.float) y.backward(v) print(x.grad) print(x.requires_grad) print((x**2).requires_grad) # 使用一下语句停止从跟踪历史中.require_gra=True的张量自动求导 with torch.no_grad(): print((x**2).requires_grad)

运行结果

总结

本篇文章就到这里了,希望能够给你带来帮助,也希望您能够多多关注服务器之家的更多内容!

原文链接:https://blog.csdn.net/qq_43368987/article/details/120899587