爬虫:一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息,一般来说,python爬虫程序很多时候都要使用(飞猪ip)代理的ip地址来爬取程序,但是默认的urlopen是无法使用代理的ip的,我就来分享一下python爬虫怎样使用代理ip的经验。(推荐飞猪代理ip注册可免费使用,浏览器搜索可找到)

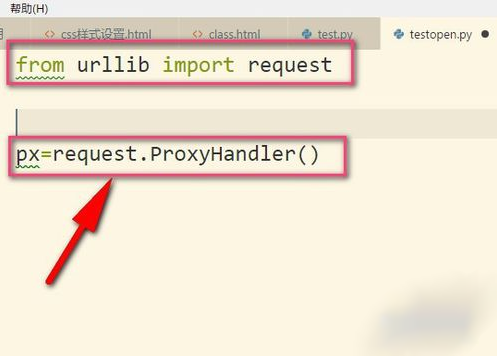

1、划重点,小编我用的是python3哦,所以要导入urllib的request,然后我们调用proxyhandler,它可以接收代理ip的参数。代理可以根据自己需要选择,当然免费的也是有的,但是可用率可想而知的。(飞猪ip)

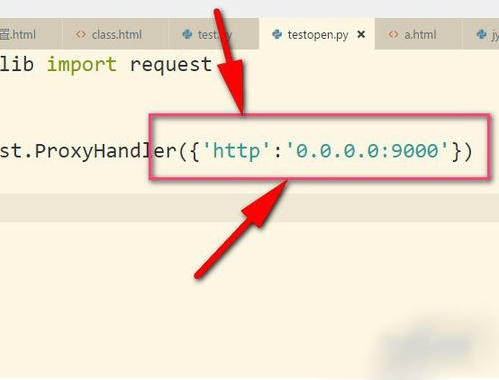

2、接着把ip地址以字典的形式放入其中,这个ip地址是我乱写的,只是用来举例。设置键为http,当然有些是https的,然后后面就是ip地址以及端口号(9000),具体看你的ip地址是什么类型的,不同ip端口号可能不同根据你在飞猪提取的端口为准。

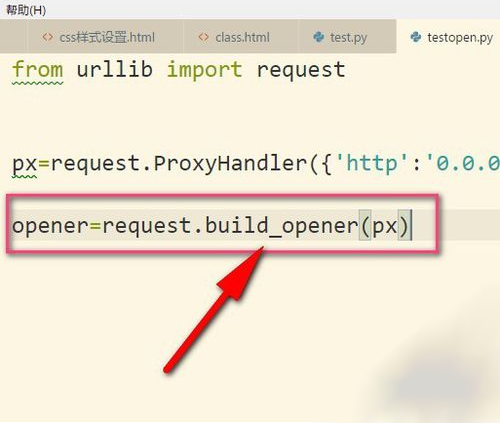

3、接着再用build_opener()来构建一个opener对象。

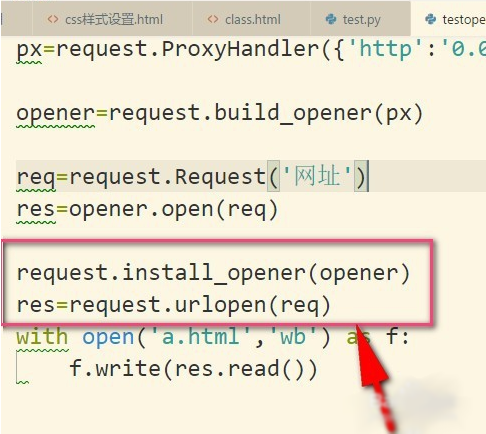

4、然后调用构建好的opener对象里面的open方法来发生请求。实际上urlopen也是类似这样使用内部定义好的opener.open(),这里就相当于我们自己重写。

5、当然了,如果我们使用install_opener(),就可以把之前自定义的opener设置成全局的。

6、设置成全局之后,如果我们再使用urlopen来发送请求,那么发送请求使用的ip地址就是代理ip,而不是本机的ip地址了。

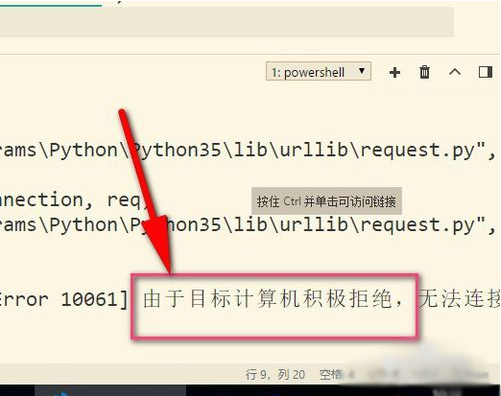

7、最后再来说说使用代理遇到的错误,提示目标计算机积极拒绝,这就说明可能是代理ip无效,或者端口号错误,这就需要使用有效的ip才行哦。(这边现在是乱填写的ip地址)可选择飞猪的代理ip。

总结:以上就是本次关于python数据抓取爬虫代理防封ip方法,感谢大家的阅读和对服务器之家的支持。

原文链接:https://jingyan.baidu.com/article/49711c61b54ac9fa441b7c9c.html