重复造轮子,这里使用重新打包生成一个基于docker的hadoop镜像;

hadoop集群依赖的软件分别为:jdk、ssh等,所以只要这两项还有hadoop相关打包进镜像中去即可;

配置文件准备

1、hadoop相关配置文件:core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml、slaves、hadoop-env.sh

2、ssh配置文件:ssh_config

3、hadoop集群启动文件:start-hadoop.sh

制作镜像

1、安装依赖

|

1

2

|

run apt-get update && \ apt-get install -y openssh-server openjdk-8-jdk wget |

2、下载hadoop包

|

1

2

3

4

5

|

run wget http://mirror.bit.edu.cn/apache/hadoop/common/hadoop-2.10.0/hadoop-2.10.0.tar.gz && \tar -xzvf hadoop-2.10.0.tar.gz && \mv hadoop-2.10.0 /usr/local/hadoop && \rm hadoop-2.10.0.tar.gz && \rm /usr/local/hadoop/share/doc -rf |

3、配置环境变量

|

1

2

3

|

env java_home=/usr/lib/jvm/java-8-openjdk-amd64 env hadoop_home=/usr/local/hadoop env path=$path:/usr/local/hadoop/bin:/usr/local/hadoop/sbin |

4、生成ssh key,用于节点免密登录

|

1

2

|

run ssh-keygen -t rsa -f ~/.ssh/id_rsa -p '' && \cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys |

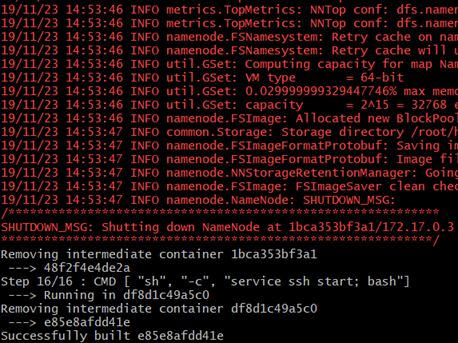

5、创建hadoop相关目录、复制相关配置文件、相关文件添加执行权限,最后格式化namenode节点,各个节点启动时,启动ssh服务;

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

run mkdir -p ~/hdfs/namenode && \ mkdir -p ~/hdfs/datanode && \mkdir $hadoop_home/logscopy config/* /tmp/#复制ssh、hadoop配置相关run mv /tmp/ssh_config ~/.ssh/config && \mv /tmp/hadoop-env.sh /usr/local/hadoop/etc/hadoop/hadoop-env.sh && \mv /tmp/hdfs-site.xml $hadoop_home/etc/hadoop/hdfs-site.xml && \ mv /tmp/core-site.xml $hadoop_home/etc/hadoop/core-site.xml && \mv /tmp/mapred-site.xml $hadoop_home/etc/hadoop/mapred-site.xml && \mv /tmp/yarn-site.xml $hadoop_home/etc/hadoop/yarn-site.xml && \mv /tmp/slaves $hadoop_home/etc/hadoop/slaves && \mv /tmp/start-hadoop.sh ~/start-hadoop.sh && \mv /tmp/run-wordcount.sh ~/run-wordcount.sh#添加执行权限run chmod +x ~/start-hadoop.sh && \chmod +x ~/run-wordcount.sh && \chmod +x $hadoop_home/sbin/start-dfs.sh && \chmod +x $hadoop_home/sbin/start-yarn.sh # format namenoderun /usr/local/hadoop/bin/hdfs namenode -format |

在docker中跑hadoop集群

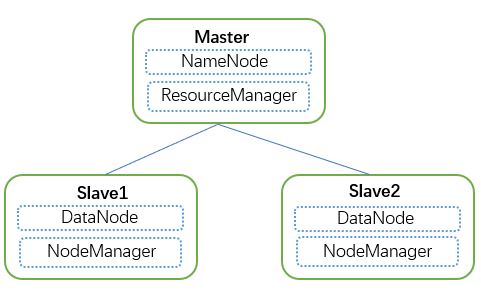

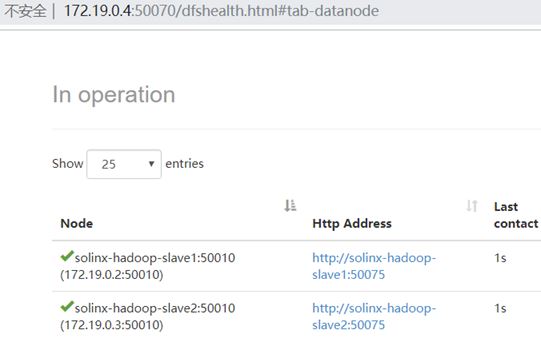

通过上面的dockerfile生成了镜像后,这里即可使用上面所生成的镜像搭建hadoop集群;这里启动一个master、两个slave节点;

添加桥接网络:

|

1

|

docker network create --driver=bridge solinx-hadoop |

启动master节点:

|

1

|

docker run -itd --net=solinx-hadoop -p 10070:50070 -p 8088:8088 --name solinx-hadoop-master --hostname solinx-hadoop-master solinx/hadoop:0.1 |

启动slave1节点:

|

1

|

docker run -itd --net=solinx-hadoop --name solinx-hadoop-slave1 --hostname solinx-hadoop-slave1 solinx/hadoop:0.1 |

启动slave2节点:

|

1

|

docker run -itd --net=solinx-hadoop --name solinx-hadoop-slave2 --hostname solinx-hadoop-slave1 solinx/hadoop:0.1 |

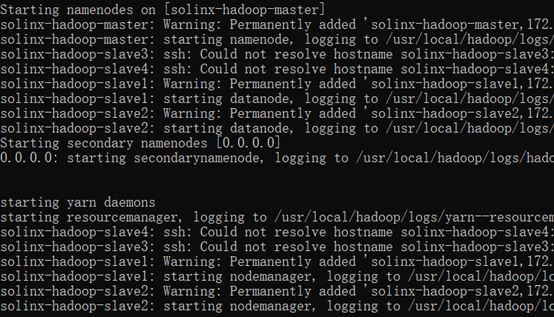

进入master节点,执行启动hadoop集群脚本即可:

总结

以上所述是小编给大家介绍的在docker中跑hadoop与镜像制作,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对服务器之家网站的支持!

如果你觉得本文对你有帮助,欢迎转载,烦请注明出处,谢谢!原文链接:https://www.cnblogs.com/softlin/archive/2019/11/25/11924731.html