本文实例为大家分享了用简单的神经网络来训练和测试的具体代码,供大家参考,具体内容如下

刚开始学习tf时,我们从简单的地方开始。卷积神经网络(cnn)是由简单的神经网络(nn)发展而来的,因此,我们的第一个例子,就从神经网络开始。

神经网络没有卷积功能,只有简单的三层:输入层,隐藏层和输出层。

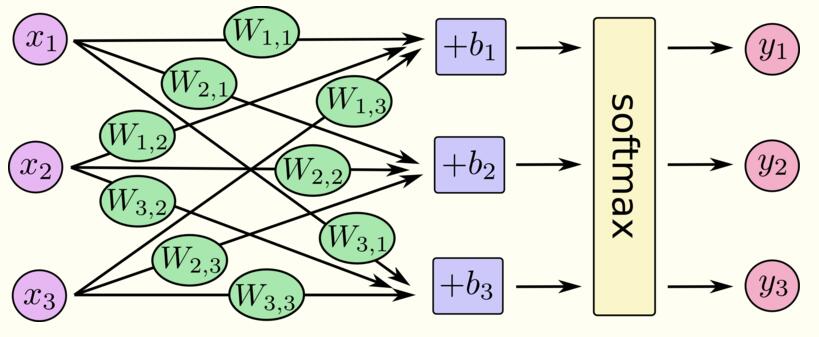

数据从输入层输入,在隐藏层进行加权变换,最后在输出层进行输出。输出的时候,我们可以使用softmax回归,输出属于每个类别的概率值。借用极客学院的图表示如下:

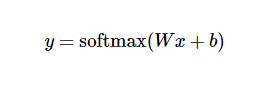

其中,x1,x2,x3为输入数据,经过运算后,得到三个数据属于某个类别的概率值y1,y2,y3. 用简单的公式表示如下:

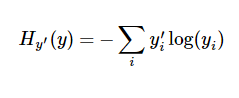

在训练过程中,我们将真实的结果和预测的结果相比(交叉熵比较法),会得到一个残差。公式如下:

y是我们预测的概率值,y'是实际的值。这个残差越小越好,我们可以使用梯度下降法,不停地改变w和b的值,使得残差逐渐变小,最后收敛到最小值。这样训练就完成了,我们就得到了一个模型(w和b的最优化值)。

完整代码如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

import tensorflow as tfimport tensorflow.examples.tutorials.mnist.input_data as input_datamnist = input_data.read_data_sets("mnist_data/", one_hot=true)x = tf.placeholder(tf.float32, [none, 784])y_actual = tf.placeholder(tf.float32, shape=[none, 10])w = tf.variable(tf.zeros([784,10])) #初始化权值wb = tf.variable(tf.zeros([10])) #初始化偏置项by_predict = tf.nn.softmax(tf.matmul(x,w) + b) #加权变换并进行softmax回归,得到预测概率cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_actual*tf.log(y_predict),reduction_indies=1)) #求交叉熵train_step = tf.train.gradientdescentoptimizer(0.01).minimize(cross_entropy) #用梯度下降法使得残差最小correct_prediction = tf.equal(tf.argmax(y_predict,1), tf.argmax(y_actual,1)) #在测试阶段,测试准确度计算accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float")) #多个批次的准确度均值init = tf.initialize_all_variables()with tf.session() as sess: sess.run(init) for i in range(1000): #训练阶段,迭代1000次 batch_xs, batch_ys = mnist.train.next_batch(100) #按批次训练,每批100行数据 sess.run(train_step, feed_dict={x: batch_xs, y_actual: batch_ys}) #执行训练 if(i%100==0): #每训练100次,测试一次 print "accuracy:",sess.run(accuracy, feed_dict={x: mnist.test.images, y_actual: mnist.test.labels}) |

每训练100次,测试一次,随着训练次数的增加,测试精度也在增加。训练结束后,1w行数据测试的平均精度为91%左右,不是太高,肯定没有cnn高。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持服务器之家。

原文链接:http://www.cnblogs.com/denny402/p/5852983.html