写在前面

好久没更新blog了,从crud boy转型大数据开发,拉宽了不少的知识面,从今年年初开始筹备、组建、招兵买马,到现在稳定开搞中,期间踏过无数的火坑,也许除了这篇还很写上三四篇。

进入主题,通常企业为了实现数据统计、数据分析、数据挖掘、解决信息孤岛等全局数据的系统化运作管理 ,为bi、经营分析、决策支持系统等深度开发应用奠定基础,挖掘数据价值 ,企业会开始着手建立数据仓库,数据中台。而这些数据来源则来自于企业的各个业务系统的数据或爬取外部的数据,从业务系统数据到数据仓库的过程就是一个etl(extract-transform-load)行为,包括了采集、清洗、数据转换等主要过程,通常异构数据抽取转换使用sqoop、datax等,日志采集flume、logstash、filebeat等。

数据抽取分为全量抽取和增量抽取,全量抽取类似于数据迁移或数据复制,全量抽取很好理解;增量抽取在全量的基础上做增量,只监听、捕捉动态变化的数据。如何捕捉数据的变化是增量抽取的关键,一是准确性,必须保证准确的捕捉到数据的动态变化,二是性能,不能对业务系统造成太大的压力。

增量抽取方式

通常增量抽取有几种方式,各有优缺点。

1. 触发器

在源数据库上的目标表创建触发器,监听增、删、改操作,捕捉到数据的变更写入临时表。

优点:操作简单、规则清晰,对源表不影响;

缺点:对源数据库有侵入,对业务系统有一定的影响;

2. 全表比对

在etl过程中,抽取方建立临时表待全量抽取存储,然后在进行比对数据。

优点:对源数据库、源表都无需改动,完全交付etl过程处理,统一管理;

缺点:etl效率低、设计复杂,数据量越大,速度越慢,时效性不确定;

3. 全表删除后再插入

在抽取数据之前,先将表中数据清空,然后全量抽取。

优点:etl 操作简单,速度快。

缺点:全量抽取一般采取t+1的形式,抽取数据量大的表容易对数据库造成压力;

4. 时间戳

时间戳的方式即在源表上增加时间戳列,对发生变更的表进行更新,然后根据时间戳进行提取。

优点:操作简单,elt逻辑清晰,性能比较好;

缺点:对业务系统有侵入,数据库表也需要额外增加字段。对于老的业务系统可能不容易做变更。

5. cdc方式

变更数据捕获change data capture(简称cdc),sqlserver为实时更新数据同步提供了cdc机制,类似于mysql的binlog,将数据更新操作维护到一张cdc表中。开启cdc的源表在插入insert、更新update和删除delete活动时会插入数据到日志表中。cdc通过捕获进程将变更数据捕获到变更表中,通过cdc提供的查询函数,可以捕获这部分数据。详情可以查看官方介绍:关于变更数据捕获 (sql server)

优点:提供易于使用的api 来设置cdc 环境,缩短etl 的时间,无需修改业务系统表结构。

缺点:受数据库版本的限制,实现过程相对复杂。

cdc增量抽取

先决条件

1. 已搭建好kafka集群,zookeeper集群;

2. 源数据库支持cdc,版本采用开发版或企业版。

案例环境:

ubuntu 20.04

kafka2.13-2.7.0

zookeeper 3.6.2

sql server 2012

步骤

除了数据库开启cdc支持以外,主要还是要将变更的数据通过kafka connect传输数据,debezium是目前官方推荐的连接器,它支持绝大多数主流数据库:mysql、postgresql、sql server、oracle等等,详情查看connectors。

1. 数据库步骤

开启数据库cdc支持

在源数据库执行以下命令:

exec sys.sp_cdc_enable_db go

附上关闭语句:

exec sys.sp_cdc_disable_db

查询是否启用

|

1

|

select * from sys.databases where is_cdc_enabled = 1 |

创建测试数据表:(已有表则跳过此步骤)

|

1

2

3

4

5

6

7

8

|

create table t_liocdc( id int identity(1,1) primary key , name nvarchar(16), sex bit, createtime datetime, updatetime datetime); |

对源表开启cdc支持:

|

1

2

3

4

5

|

exec sp_cdc_enable_table @source_schema='dbo', @source_name='t_liocdc', @role_name=null,@supports_net_changes = 1; |

确认是否有权限访问cdc table:

exec sys.sp_cdc_help_change_data_capture

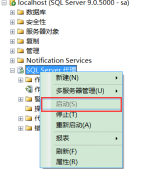

确认sql server agent已开启:

exec master.dbo.xp_servicecontrol n'querystate',n'sqlserveragent'

以上则完成对数据库的cdc操作。

2. kafka步骤

kafka connect的工作模式分为两种,分别是standalone模式和distributed模式。standalone用于单机测试,本文用distributed模式,用于生产环境。(kafka必须先运行启动,再进行以下步骤进行配置。)

下载sql server connector

下载连接器后,创建一个文件夹来存放,解压到该目录下即可,例子路径:/usr/soft/kafka/kafka_2.13_2.7.0/plugins(记住这个路径,配置中要用到)

下载地址:debezium-connector-sqlserver-1.5.0.final-plugin.tar.gz

编辑connect-distributed.properties配置

修改kafka connect配置文件,$kafka_home/config/connect-distributed.properties,变更内容如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

//kafka集群ip+portbootstrap.servers=172.192.10.210:9092,172.192.10.211:9092,172.192.10.212:9092key.converter.schemas.enable=falsevalue.converter.schemas.enable=falseoffset.storage.topic=connect-offsetsoffset.storage.replication.factor=1offset.storage.partitions=3offset.storage.cleanup.policy=compactconfig.storage.topic=connect-configsconfig.storage.replication.factor=1status.storage.topic=connect-statusstatus.storage.replication.factor=1status.storage.partitions=3//刚刚下载连接器解压的路径plugin.path=/usr/soft/kafka/kafka_2.13_2.7.0/plugins |

看到配置中有三个topic,分别是

config.storage.topic:用以保存connector和task的配置信息,需要注意的是这个主题的分区数只能是1,而且是有多副本的。

offset.storage.topic:用以保存offset信息。

status.storage.topic:用以保存connetor的状态信息。

这些topic可以不用创建,启动后会默认创建。

启动kafka集群

保存配置之后,将connect-distributed.properties分发到集群中,然后启动:

bin/connect-distributed.sh config/connect-distributed.properties

检查是否启动

connector支持rest api的方式进行管理,所以用post man或者fiddler可以调用相关接口进行管理。检查是否启动:

不用奇怪,上面配置集群的ip是172段,这里的192.168.1.177仍是我的集群中的一个服务器,因为服务器都使用了双网卡。因为还没有连接器相关配置,所以接口返回是一个空数组,接下来将新增一个连接器。

编写sqlserver-cdc-source.json

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

{ "name": "sqlserver-cdc-source", "config": { "connector.class" : "io.debezium.connector.sqlserver.sqlserverconnector", "database.server.name" : "jnserver", "database.hostname" : "172.192.20.2", --目标数据库的ip "database.port" : "1433", --目标数据库的端口 "database.user" : "sa", --目标数据库的账号 "database.password" : "123456", --密码 "database.dbname" : "dis", --目标数据库的数据库名称 "table.whitelist": "dbo.t_liocdc", --监听表名 "schemas.enable" : "false", "mode":"incrementing", --增量模式 "incrementing.column.name": "id", --增量列名 "database.history.kafka.bootstrap.servers" : "172.192.10.210:9092,172.192.10.211:9092,172.192.10.212", --kafka集群 "database.history.kafka.topic": "topictliocdc", --kafka topic内部使用,不是由消费者使用 "value.converter.schemas.enable":"false", "value.converter":"org.apache.kafka.connect.json.jsonconverter" }}//源文地址: https://www.cnblogs.com/eminemjk/p/14688907.html |

还有其他额外的配置,可以参考官方文档。然后执行

继续执行检查,就发现连接器已经成功配置了:

其他api

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

get /connectors – 返回所有正在运行的connector名。post /connectors – 新建一个connector; 请求体必须是json格式并且需要包含name字段和config字段,name是connector的名字,config是json格式,必须包含你的connector的配置信息。get /connectors/{name} – 获取指定connetor的信息。get /connectors/{name}/config – 获取指定connector的配置信息。put /connectors/{name}/config – 更新指定connector的配置信息。get /connectors/{name}/status – 获取指定connector的状态,包括它是否在运行、停止、或者失败,如果发生错误,还会列出错误的具体信息。get /connectors/{name}/tasks – 获取指定connector正在运行的task。get /connectors/{name}/tasks/{taskid}/status – 获取指定connector的task的状态信息。put /connectors/{name}/pause – 暂停connector和它的task,停止数据处理知道它被恢复。put /connectors/{name}/resume – 恢复一个被暂停的connector。post /connectors/{name}/restart – 重启一个connector,尤其是在一个connector运行失败的情况下比较常用post /connectors/{name}/tasks/{taskid}/restart – 重启一个task,一般是因为它运行失败才这样做。delete /connectors/{name} – 删除一个connector,停止它的所有task并删除配置。//源文地址: https://www.cnblogs.com/eminemjk/p/14688907.html |

查看topic

/usr/soft/kafka/kafka_2.13_2.7.0# bin/kafka-topics.sh --list --zookeeper localhost:2000

topicjnserver.dbo.t_liocdc则是供我们消费的主题,启动一个消费者进行监听测试:

bin/kafka-console-consumer.sh --bootstrap-server 172.192.10.210:9092 --consumer-property group.id=group1 --consumer-property client.id=consumer-1 --topic jnserver.dbo.t_liocdc

然后再源表进行一些列增删改操作,

|

1

2

3

4

5

6

7

8

9

10

11

12

|

--测试代码insert into t_liocdc(name, sex, createtime,updatetime) values ('a',1,getdate(),getdate())insert into t_liocdc(name, sex, createtime,updatetime) values ('b',0,getdate(),getdate())insert into t_liocdc(name, sex, createtime,updatetime) values ('c',1,getdate(),getdate())insert into t_liocdc(name, sex, createtime,updatetime) values ('d',0,getdate(),getdate())insert into t_liocdc(name, sex, createtime,updatetime) values ('e',1,getdate(),getdate())insert into t_liocdc(name, sex, createtime,updatetime) values ('f',1,getdate(),getdate())insert into t_liocdc(name, sex, createtime,updatetime) values ('g',0,getdate(),getdate())update t_liocdcset name='lio.huang',updatetime=getdate()where id=7 |

已经成功捕捉到数据的变更,对比几个操作json,依次是insert、update、delete:

到此这篇关于sql server cdc配合kafka connect监听数据变化的文章就介绍到这了,更多相关sql server cdc监听数据变化内容请搜索服务器之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持服务器之家!

原文链接:https://www.cnblogs.com/EminemJK/p/14688907.html