前言

celery是一个异步任务队列。它可以用于需要异步运行的任何内容。rabbitmq是celery广泛使用的消息代理。在本这篇文章中,我将使用rabbitmq来介绍celery的基本概念,然后为一个小型演示项目设置celery 。最后,设置一个celery web控制台来监视我的任务

基本概念

来!看图说话:

broker

broker(rabbitmq)负责创建任务队列,根据一些路由规则将任务分派到任务队列,然后将任务从任务队列交付给worker

consumer (celery workers)

consumer是执行任务的一个或多个celery workers。可以根据用例启动许多workers

result backend

后端用于存储任务的结果。但是,它不是必需的元素,如果不在设置中包含它,就无法访问任务的结果

安装celery

首先,需要安装好celery,可以使用pypi:

|

1

|

pip install celery |

选择一个broker:rabbitmq

为什么我们需要broker呢?这是因为celery本身并不构造消息队列,所以它需要一个额外的消息传输来完成这项工作。这里可以将celery看作消息代理的包装器

实际上,也可以从几个不同的代理中进行选择,比如rabbitmq、redis或数据库(例如django数据库)

在这里使用rabbitmq作为代理,因为它功能完整、稳定,celery推荐使用它。由于演示我的环境是在mac os中,安装rabbitmq使用homebrew即可:

|

1

2

|

brew install rabbitmq#如果是ubuntu的话使用apt-get安装 |

启动rabbitmq

程序将在/usr/local/sbin中安装rabbitmq,虽然有些系统可能会有所不同。可以将此路径添加到环境变量路径,以便以后方便地使用。例如,打开shell启动文件~/.bash_profile添加:

|

1

|

path=$path:/usr/local/sbin |

现在,可以使用rabbitmq-server命令启动我们的rabbitmq服务器。检查rabbitmq服务器成功启动,将看到类似的输出:

为celery配置rabbitmq

rabbitmq使用celery之前,需要对rabbitmq进行一些配置。简单地说,我们需要创建一个虚拟主机和用户,然后设置用户权限,以便它可以访问虚拟主机

|

1

2

3

4

5

6

7

8

|

# 添加用户跟密码$ rabbitmqctl add_user test test123# 添加虚拟主机$ rabbitmqctl add_vhost test_vhost# 为用户添加标签$ rabbitmqctl set_user_tags test test_tag# 设置用户权限$ rabbitmqctl set_permissions -p test_vhost test ".*" ".*" ".*" |

敲黑板!rabbitmq中有三种操作:配置、写入和读取

上面命令末尾的字符串表示用户test将拥有所有配置、写入和读取权限

演示项目

现在让我们创建一个简单的项目来演示celery的使用

在celery.py中添加以下代码:

|

1

2

3

4

5

6

7

|

from __future__ import absolute_importfrom celery import celeryapp = celery('test_celery',broker='amqp://test:test123@localhost/test_vhost',backend='rpc://',include=['test_celery.tasks']) |

在这里,初始化了一个名为app的celery实例,将用于创建一个任务。celery的第一个参数只是项目包的名称,即“test_celery”。

broker参数指定代理url,对于rabbitmq,传输是amqp。

后端参数指定后端url。celery中的后端用于存储任务结果。因此,如果需要在任务完成时访问任务的结果,应该为celery设置一个后端。

rpc意味着将结果作为amqp消息发送回去,这对本次演示来说是一种可接受的格式

include参数指定了在celery工作程序启动时要导入的模块列表。我们在这里添加了tasks模块,以便找到我们的任务。

在tasks.py这个文件中,定义了我们的任务add_longtime:

|

1

2

3

4

5

6

7

8

9

10

11

|

from __future__ import absolute_importfrom test_celery.celery import appimport time@app.taskdef add_longtime(a, b): print 'long time task begins' # sleep 5 seconds time.sleep(5) print 'long time task finished' return a + b |

可以看到,导入了在前面的celery模块中定义的应用程序,并将其用作任务方法的装饰器。另外注意!app.task只是一个装饰器。此外,我们在add_longtime任务中休眠5秒,以模拟一个耗时较长的task

在设置好celery之后,我们需要开始运行任务,它包含在runs_tasks.py:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

from .tasks import add_longtimeimport timeif __name__ == '__main__': result = add_longtime.delay(1,2) #此时,任务还未完成,它将返回false print 'task finished? ', result.ready() print 'task result: ', result.result # 延长到10秒以确保任务已经完成 time.sleep(10) # 现在任务完成,ready方法将返回true print 'task finished? ', result.ready() print 'task result: ', result.result |

这里,我们使用delay方法调用任务add_longtime,如果我们想异步处理任务,就需要使用delay方法。此外,保存任务的结果并打印一些信息。如果任务已经完成,ready方法将返回true,否则返回false。result属性是任务的结果,如果任务尚未完成,则返回none。

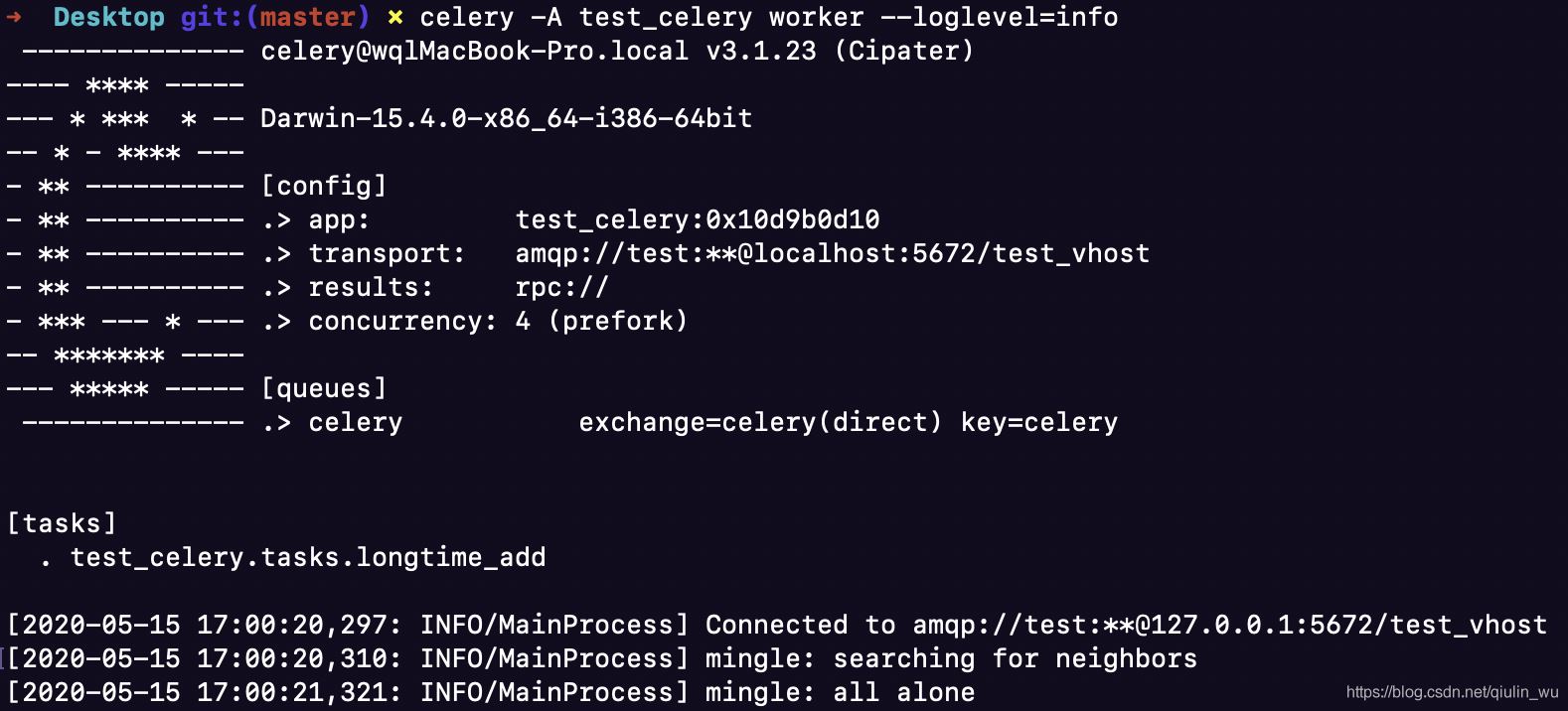

启动celery

现在,可以使用下面的命令启动celery(注:在项目文件夹中运行):

|

1

|

celery -a test_celery worker --loglevel=info |

celery成功连接到rabbitmq,你会看到这样的东西:

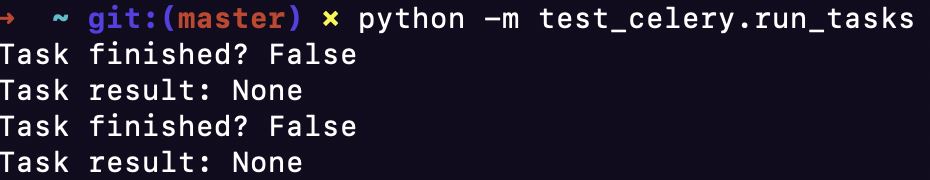

运行任务

再项目文件中输入以下命令运行它:

|

1

|

python -m test_celery.run_tasks |

查看celery控制台,看到运行任务:

[2020-05-15 17:15:21,508: info/mainprocess]

received task: test_celery.tasks.add_longtime[25ba9c87-69a7-4383-b983-1cefdb32f8b3]

[2020-05-15 17:15:21,508: warning/worker-3] long time task begins

[2020-05-15 17:15:31,510: warning/worker-3] long time task finished

[2020-05-15 17:15:31,512: info/mainprocess]

task test_celery.tasks.add_longtime[25ba9c87-69a7-4383-b983-1cefdb32f8b3] succeeded in 15.003732774s: 3

当celery收到一个任务,它打印出任务名称与任务id(在括号中):

received task: test_celery.tasks.add_longtime[7d942984-8ea6-4e4d-8097-225616f797d5]

在这一行下面是我们的任务add_longtime打印的两行,时间延迟为5秒:

|

1

2

|

long time task beginslong time task finished |

最后一行显示我们的任务在5秒内完成,任务结果为3:

|

1

|

task test_celery.tasks.add_longtime[7d942984-8ea6-4e4d-8097-225616f797d5] succeeded in 5.025242167s: 3 |

在当前控制台中,您将看到以下输出:

实时监控celery

flower是一款基于网络的celery实时监控软件。使用flower,可以轻松地监视任务进度和历史记录

使用pip来安装flower:

|

1

|

pip install flower |

要启动flower web控制台,需要运行以下命令:

|

1

|

celery -a test_celery flower |

flower将运行具有默认端口5555的服务器,可以通过http://localhost:5555访问web控制台

到此这篇关于详解python celery和rabbitmq实战教程的文章就介绍到这了,更多相关python celery和rabbitmq实战内容请搜索服务器之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持服务器之家!

原文链接:https://blog.csdn.net/qiulin_wu/article/details/106119757