搜索引擎蜘蛛低爬行率和不完整的收录是很多站点存在的问题,特别是针对那些大型网站和新站,在很多论坛和网站我看到有人问到如何解决这个问题,很多我的SEO客户也在问我这个问题,下面给大家一些解答,当然,个人对谷歌比较了解,所以解答主要针对于谷歌进行,当然,同样的法则也适用于其他搜索引擎的SEO优化中,包括百度,雅虎等等。

首先,谷歌的收录率对于大型网站来说很难去计算,收录数量由于各种原因可能并不是真实收录数量,所以我们得出的收录率对于大型网站来说并不准确,谷歌提供的webmaster工具可能要好一些,里面收录的信息更有可信性,但是,如果你的站点确实太大,那么收录多少肯能真的无法准确得出。当然,如果你硬要计算出网站的收录率,对大网站来说,不如随机选取几十个界面,手动查询每个界面是否收录,通过概率的方法,大致得到收录率,当然,这也不可能绝对准确。

蜘蛛的爬行和收录不可能被准确的控制,但是我们可以用一些积极的因素来影响它,尽量的让它收录的更好,下面具体分析:

1.域名重要性,谷歌的MATT CUTTS最近接受采访的时候承认,网站的收录率和蜘蛛爬行深度和PR大概成正比关系,也就是说,PR越高,你的站收录绝对会越好。

2.反向链接,PR是基于反相链接的,于是,它当然会成为影响收录的主要原因,一个站点内容增加迅速,但是链接增加缓慢,搜索引擎会认为你的站点比较垃圾。

3.深度链接,深度链接就是指向内容页面的反向链接,这些链接会让你的内页有非常好的SEO优化效果,有深度链接的页面排名和收录都会非常不错。

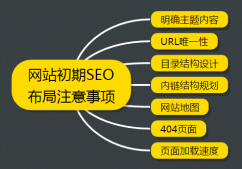

4.导航栏和清晰的层次,对于网站,扁平结构最为合理,可以让搜索引擎很好的识别你的内容,更方便收录,同时要有明确的导航,让最重要的页面,无论在哪里都可以在4次点击之内进入,最好2次以内,这样搜索引擎会更好的识别抓取重要页面。

5.XML 网站地图,这是一个必须要做的事情,网页的地图一定会帮助你的网站提高收录和收录速度,毋庸置疑。

6.减少雷同内容,在做网站时,一定尽量多的原创,搜索引擎可以根据模糊匹配很好的识别雷同内容,从而不会给予高权重,大家可以看看信息论,深入了解一下雷同网页如何分配权重的规则,目前百度等搜索引擎基本都是以信息论为这方面的计算核心。

7.别致的标题,如果你的标题已经存在很多同样的文章,那么搜索引擎会考虑是不是有必要收录,所以标题要尽量别致一些。

8.手动设置更新频率,在提交网站地图时手动设置网站更新频率,尽量让搜索引擎快些更新站点。

9.更新,回复,Ping命令,经常对内页和主页进行更新维护,细节上的,而不是整体的,这样做会很好的提升爬虫爬行效率,同时多的回复也能提高你的首旅率,RSS要充分利用,因为那可以理解成一个自动生成的网站地图,建议把RSS也提交给搜索引擎。

10.社交网络,尽管类似于校内的这些社交网的链接可能用了nofollow标签,但是谷歌也有针对这些社交网站的计算方法,在社交网站多一些你网站的内容,相信也会提升你的网页网页收录率。