目标

最近实验室里成立了一个计算机兴趣小组

倡议大家多把自己解决问题的经验记录并分享

就像在csdn写博客一样

虽然刚刚起步

但考虑到后面此类经验记录的资料会越来越多

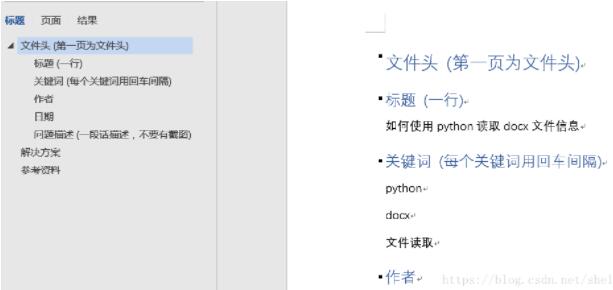

所以一开始就要做好模板设计(如下所示)

方便后面建立电子数据库

从而使得其他人可以迅速地搜索到相关记录

据说“人生苦短,我用python”

所以决定用python从docx文档中提取文件头的信息

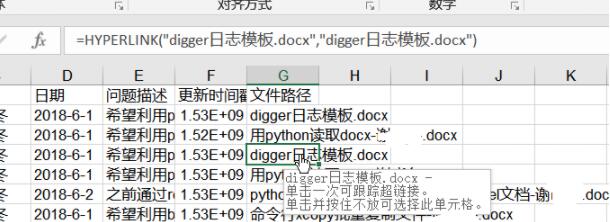

然后把信息更新到一个xls电子表格中,像下面这样(直接po结果好了)

而且点击文件路径可以直接打开对应的文件(含超链接)

代码实现

1. 采集docx里面文件头信息

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

|

# -*- coding:utf-8 -*- # 此程序可扫描log中的docx文件并返回基本信息 word">import docxfrom docx import document test_d = '../log/sublime搭建python的集成开发环境.docx' def docxinfo(addr): document = document(addr) info = {'title':[], 'keywords':[], 'author':[], 'date':[], 'question':[]} lines = [0 for i in range(len(document.paragraphs))] k = 0 for paragraph in document.paragraphs: lines[k] = paragraph.text k = k+1 index = [0 for i in range(5)] k = 0 for line in lines: if line.startswith('标题'): index[0] = k if line.startswith('关键词'): index[1] = k if line.startswith('作者'): index[2] = k if line.startswith('日期'): index[3] = k if line.startswith('问题描述'): index[4] = k k = k+1 info['title'] = lines[index[0]+1] keywords = [] for line in lines[index[1]+1:index[2]]: keywords.append(line) info['keywords'] = keywords info['author'] = lines[index[2]+1] info['date'] = lines[index[3]+1] info['question'] = lines[index[4]+1] return info if __name__ == '__main__': print(docxinfo(test_d)) |

2. 遍历log文件夹,进行信息更新

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

|

# -*- coding:utf-8 -*- # 此程序可以批量扫描log中的文件,如果碰到docx文档,# 则调用readfile()提取文档信息,并将信息保存到digger# 日志列表.xls之中,方便后期快速检索 import os,datetimeimport timeimport xlrdfrom xlrd import xldate_as_tupleimport xlwtfrom readfile import docxinfofrom xlutils.copy import copy # 打开日志列表读取最近一条记录的更新日期memo_d = '../log/digger日志列表.xls'sheet0 = memo.sheet_by_index(0) #读取第1张表memo_date = sheet0.col_values(5) #读取第5列memo_n = len(memo_date) #去掉标题if memo_n>0: xlsx_date = memo_date[memo_n-1] #读取最后一条记录的日期, latest_date = sheet0.cell_value(memo_n-1,5) # 返回时间戳 # 新建一个xlsxmemo_new = copy(memo)sheet1 = memo_new.get_sheet(0) # 重建超链接hyperlinks = sheet0.col_values(6) # xlrd读取的也是text,造成超链接丢失k = 1n_hyperlink = len(hyperlinks)for k in range(n_hyperlink): link = 'hyperlink("%s";"%s")' %(hyperlinks[k],hyperlinks[k]) sheet1.write(k,6,xlwt.formula(link)) k = k+1 # 判断文件后缀def endwith(s,*endstring): array = map(s.endswith,endstring) if true in array: return true else: return false # 遍历log文件夹并进行查询log_d = '../log'logfiles = os.listdir(log_d)for file in logfiles: if endwith(file,'.docx'): timestamp = os.path.getmtime(log_d+'/'+file) if timestamp>latest_date: info = docxinfo(log_d+'/'+file) sheet1.write(memo_n,0,info['title']) keywords_text = ','.join(info['keywords']) sheet1.write(memo_n,1,keywords_text) sheet1.write(memo_n,2,info['author']) sheet1.write(memo_n,3,info['date']) sheet1.write(memo_n,4,info['question']) #获取当前时间 time_now = time.time() #浮点值,精确到毫秒 sheet1.write(memo_n,5, time_now) link = 'hyperlink("%s";"%s")' %(file,file) sheet1.write(memo_n,6,xlwt.formula(link)) memo_n = memo_n+1os.remove(memo_d)memo_new.save(memo_d)print('memo was updated!') |

其实还有一些操作电子表格更好的模块,比如panda、xlsxwriter、openpyxl等。不过上述代码已经基本能实现功能,而且科研狗毕竟没那么多时间写代码做调试,所以后面有空再update吧!

致谢

在此过程中大量借鉴了csdn论坛中各位大神的各种经验!!!

以上这篇使用python批量读取word文档并整理关键信息到excel表格的实例就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持服务器之家。

原文链接:https://blog.csdn.net/sheldonxxd/article/details/80544831