写在前面:

请参考之前的文章安装好centos、nvidia相关驱动及软件、docker及加速镜像。

主机运行环境

|

1

2

3

4

5

6

7

8

9

10

11

|

$ uname -alinux centos 3.10.0-514.26.2.el7.x86_64 #1 smp tue jul 4 15:04:05 utc 2017 x86_64 x86_64 x86_64 gnu/linux$ cat /usr/local/cuda/version.txtcuda version 8.0.61$ cat /usr/local/cuda/include/cudnn.h | grep cudnn_major -a 2#define cudnn_major 6#define cudnn_minor 0#define cudnn_patchlevel 21#define cudnn_version (cudnn_major * 1000 + cudnn_minor * 100 + cudnn_patchlevel)#include "driver_types.h"# nvidia 1080ti |

一、关于gpu的挂载

1. 在docker运行时指定device挂载

先查看一下有哪些相关设备

|

1

2

3

4

5

6

|

$ ls -la /dev | grep nvidiacrw-rw-rw- 1 root root 195, 0 nov 15 13:41 nvidia0crw-rw-rw- 1 root root 195, 1 nov 15 13:41 nvidia1crw-rw-rw- 1 root root 195, 255 nov 15 13:41 nvidiactlcrw-rw-rw- 1 root root 242, 0 nov 15 13:41 nvidia-uvmcrw-rw-rw- 1 root root 242, 1 nov 15 13:41 nvidia-uvm-tools |

电脑上装了两个显卡。我需要运行pytorch,dockerhub中pytorch官方镜像没有gpu支持,所以只能先pull一个anaconda镜像试试,后面可以编排成dockerfile。

|

1

|

$ docker run -it -d --rm --name pytorch -v /home/qiyafei/pytorch:/mnt/home --privileged=true --device /dev/nvidia-uvm:/dev/nvidia-uvm --device /dev/nvidia1:/dev/nvidia1 --device /dev/nvidiactl:/dev/nvidiactl okwrtdsh/anaconda3 bash |

okwrtdsh的镜像似乎是针对他们实验室gpu环境的,有点过大了,不过勉强运行一下还是可以的。在容器内部还需要

安装pytorch:

|

1

|

$ conda install pytorch torchvision -c pytorch |

这里运行torch成功,但是加载显卡失败了,可能还是因为驱动不匹配的原因吧,需要重新安装驱动,暂时不做此尝试;

二、通过nvidia-docker在docker内使用显卡

详细信息:https://github.com/nvidia/nvidia-docker

(1)安装nvidia-docker

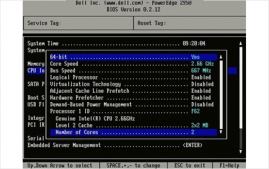

nvidia-docker其实是docker引擎的一个应用插件,专门面向nvidia gpu,因为docker引擎是不支持nvidia驱动的,安装插件后可以在用户层上直接使用cuda。具体看上图。这个图很形象,docker引擎的运行机制也表现出来了,就是在系统内核之上通过cgroup和namespace虚拟出一个容器os的用户空间,我不清楚这是否运行在ring0上,但是cuda和应用确实可以使用了(虚拟化的问题,如果关心此类问题可以了解一些关于docker、kvm等等虚拟化的实现方式,目前是系统类比较火热的话题)

下载rpm包:https://github.com/nvidia/nvidia-docker/releases/download/v1.0.1/nvidia-docker-1.0.1-1.x86_64.rpm

这里也可以通过添加apt或者yum sourcelist的方式进行安装,但是我没有root权限,而且update容易引起docker重启,如果不是实验室的个人环境不推荐这么做,防止破坏别人正在运行的程序(之前公司一个小伙子就是在阿里云上进行了yum update,结果导致公司部分业务停了一个上午)。

|

1

2

|

$ sudo rpm -i nvidia-docker-1.0.1-1.x86_64.rpm && rm nvidia-docker-1.0.1-1.x86_64.rpm$ sudo systemctl start nvidia-docker |

(2)容器测试

我们还需要nvidia官方提供的docker容器nvidia/cuda,里面已经编译安装了cuda和cudnn,或者直接run,缺少image的会自动pull。

|

1

2

|

$ docker pull nvidia/cuda$ nvidia-docker run --rm nvidia/cuda nvidia-smi |

在容器内测试是可以成功使用nvidia显卡的:

(3)合适的镜像或者自制dockerfile

合适的镜像:这里推荐floydhub的pytorch,注意对应的cuda和cudnn版本。

|

1

2

|

docker pull floydhub/pytorch:0.3.0-gpu.cuda8cudnn6-py3.22nvidia-docker run -ti -d --rm floydhub/pytorch:0.3.0-gpu.cuda8cudnn6-py3.22 bash |

自制dockerfile

首先,我们需要把要装的东西想清楚:

1. 基础镜像肯定是nvidia官方提供的啦,最省事,不用装cuda和cudnn了;

2. vim、git、lrzsz、ssh这些肯定要啦;

3. anaconda、pytorch肯定要啦;

所以需要准备好国内源source.list,否则安装速度很慢。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

deb-src http://archive.ubuntu.com/ubuntu xenial main restricted #added by software-propertiesdeb http://mirrors.aliyun.com/ubuntu/ xenial main restricteddeb-src http://mirrors.aliyun.com/ubuntu/ xenial main restricted multiverse universe #added by software-propertiesdeb http://mirrors.aliyun.com/ubuntu/ xenial-updates main restricteddeb-src http://mirrors.aliyun.com/ubuntu/ xenial-updates main restricted multiverse universe #added by software-propertiesdeb http://mirrors.aliyun.com/ubuntu/ xenial universedeb http://mirrors.aliyun.com/ubuntu/ xenial-updates universedeb http://mirrors.aliyun.com/ubuntu/ xenial multiversedeb http://mirrors.aliyun.com/ubuntu/ xenial-updates multiversedeb http://mirrors.aliyun.com/ubuntu/ xenial-backports main restricted universe multiversedeb-src http://mirrors.aliyun.com/ubuntu/ xenial-backports main restricted universe multiverse #added by software-propertiesdeb http://archive.canonical.com/ubuntu xenial partnerdeb-src http://archive.canonical.com/ubuntu xenial partnerdeb http://mirrors.aliyun.com/ubuntu/ xenial-security main restricteddeb-src http://mirrors.aliyun.com/ubuntu/ xenial-security main restricted multiverse universe #added by software-propertiesdeb http://mirrors.aliyun.com/ubuntu/ xenial-security universedeb http://mirrors.aliyun.com/ubuntu/ xenial-security multiverse |

下载anaconda的地址:https://repo.continuum.io/archive/anaconda3-5.0.1-linux-x86_64.sh,这里直接在dockerfile里下了,具体如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

$ vim dockerfilefrom nvidia/cudalabel author="qyf"env pythonioencoding=utf-8run mv /etc/apt/sources.list /etc/apt/sources.list.bakadd $pwd/sources.list /etc/apt/sources.listrun apt-get update --fix-missing && \ apt-get install -y vim net-tools curl wget git bzip2 ca-certificates libglib2.0-0 libxext6 libsm6 libxrender1 mercurial subversion apt-transport-https software-properties-commonrun apt-get install -y openssh-server -yrun echo 'root:passwd' | chpasswdrun sed -i 's/permitrootlogin prohibit-password/permitrootlogin yes/' /etc/ssh/sshd_configrun sed -i 's/#passwordauthentication yes/passwordauthentication yes/' /etc/ssh/sshd_configrun echo 'export path=/opt/conda/bin:$path' > /etc/profile.d/conda.sh && wget --quiet https://repo.continuum.io/archive/anaconda3-5.0.1-linux-x86_64.sh -o ~/anaconda.sh && /bin/bash ~/anaconda.sh -b -p /opt/conda && rm ~/anaconda.shrun apt-get install -y grep sed dpkg && \ tini_version=`curl https://github.com/krallin/tini/releases/latest | grep -o "/v.*\"" | sed 's:^..\(.*\).$:\1:'` && \ curl -l "https://github.com/krallin/tini/releases/download/v${tini_version}/tini_${tini_version}.deb"; > tini.deb && \ dpkg -i tini.deb && \ rm tini.deb && \ apt-get cleanenv path /opt/conda/bin:$pathrun conda install pytorch torchvision -c pytorch -yentrypoint [ "/usr/bin/tini", "--" ]cmd [ "/bin/bash" ] |

通过docker build构造镜像:

|

1

|

docker build -t pytorch/cuda8 ./ |

运行成功调用cuda。

三、关于一些bug

这里有部分debian的配置,我照着dockerhub上anaconda镜像抄的,这里就不再配置了,反正跑起来后有镜像也可以用。系统随后可能会出现错误:

kernel:unregister_netdevice: waiting for lo to become free. usage count = 1

这是一个ubuntu的内核错误,截止到到目前为止似乎还没完全解决。

这个小哥给出了一个解决方案,至少他给出的错误原因我是相信的:是由内核的tcp套接字错误引发的。这里我给出一些思考,关于上面的结构图,在显卡上,通过nvidia-docker,docker之上的容器可以使用到底层显卡(驱动显然是在docker之下的),而tcp套接字,我猜测也是这种使用方法,而虚拟出来的dockeros,应该是没有权限来访问宿主机内核的,至少内核限制了部分权限。这位小哥给出了测试内核,如果有兴趣可以去帮他测试一下:https://bugs.launchpad.net/ubuntu/+source/linux/+bug/1711407/comments/46。

总结

以上所述是小编给大家介绍的docker挂载nvidia显卡运行pytorch的方法,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对服务器之家网站的支持!

原文链接:https://www.cnblogs.com/mar-q/p/8417184.html